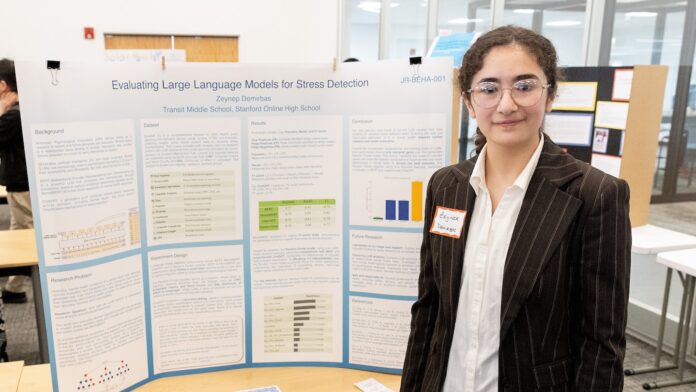

La experiencia de un estudiante de secundaria con un chatbot de inteligencia artificial (IA) ha puesto de relieve las preocupaciones sobre la dependencia de la IA para el apoyo a la salud mental. El estudiante, que compitió en el Thermo Fisher Scientific Junior Innovators Challenge, una competencia para estudiantes de secundaria organizada por la Sociedad para la Ciencia, descubrió que un modelo de IA ofrecía consejos potencialmente dañinos, lo que plantea dudas sobre la confiabilidad de estas herramientas para gestionar el bienestar emocional.

Comprender las herramientas en juego

Antes de profundizar en los detalles de los hallazgos del estudiante, es útil comprender algunas de las tecnologías clave involucradas.

- Inteligencia artificial (IA): La IA se refiere a sistemas que exhiben un comportamiento inteligente, a menudo a través de algoritmos complejos. Estos algoritmos permiten que las máquinas aprendan de los datos y tomen decisiones.

- Modelos de lenguaje grandes: Un tipo específico de IA, modelos de lenguaje grandes, se centran en comprender y generar el lenguaje humano. Han sido entrenados en conjuntos de datos masivos de texto y voz, lo que les permite predecir palabras y frases y responder a indicaciones de una manera notablemente humana. Piense en ellos como motores de predicción del lenguaje increíblemente sofisticados.

- Árboles de decisión y modelos de bosque aleatorio: Son algoritmos de aprendizaje que se utilizan para clasificar información o hacer predicciones. Un árbol de decisión plantea una serie de preguntas, reduciendo las posibilidades con cada respuesta, mientras que un modelo de bosque aleatorio combina múltiples árboles de decisión para obtener un resultado más sólido.

- Parámetros: Son las condiciones o variables medibles dentro de un sistema que pueden ajustarse o estudiarse. Ajustar estos parámetros puede optimizar el rendimiento del modelo.

El experimento del estudiante y sus implicaciones

El estudiante estaba explorando cómo se podría utilizar la IA para brindar apoyo a la salud mental, con el objetivo de desarrollar un sistema confiable. Se centraron en un chatbot diseñado para abordar el estrés y ofrecer estrategias de afrontamiento. Si bien reconocieron el potencial de la IA, las pruebas del estudiante revelaron un problema preocupante: el chatbot a veces brindaba consejos inapropiados o incluso potencialmente dañinos.

Este hallazgo subraya las limitaciones de los modelos actuales de IA a la hora de manejar los matices de las emociones y la salud mental humanas. El modelo de IA no consideró las complejidades de las circunstancias individuales ni los posibles desencadenantes, sino que ofreció respuestas genéricas que podrían ser contraproducentes.

Por qué esto es importante

Los hallazgos son especialmente relevantes dada la creciente accesibilidad de aplicaciones de salud mental y chatbots impulsados por inteligencia artificial. Si bien estas herramientas pueden ofrecer un apoyo conveniente y asequible, no deben considerarse un reemplazo de la orientación profesional de un psicólogo u otro experto en salud mental. He aquí por qué:

- Falta de comprensión contextual: Los modelos de IA funcionan en función de patrones en los datos. Les cuesta captar el contexto completo de la situación de un individuo, lo que les lleva a dar consejos que pueden no ser adecuados. El impacto del estrés psicológico puede ser positivo o negativo.

- Posible sesgo: Los modelos de IA se entrenan con datos, y si esos datos reflejan sesgos (relacionados con el género, el nivel socioeconómico, la raza u otros factores), la IA puede perpetuar esos sesgos en sus respuestas.

- Riesgo de consejos perjudiciales: Como demostró la experiencia del estudiante, la IA puede proporcionar consejos inexactos, insensibles o incluso perjudiciales. Un síntoma puede ser un signo de cualquiera de muchas lesiones o enfermedades diferentes.

Mirando hacia el futuro

El trabajo del estudiante sirve como advertencia sobre la necesidad de una evaluación y regulación cuidadosas de la IA en la salud mental. Antes de depender de la IA como apoyo emocional, es fundamental recordar que estas herramientas aún están en desarrollo y tienen limitaciones importantes.

El objetivo no debería ser sustituir la interacción humana por la IA, sino utilizar la IA de forma responsable como herramienta de apoyo bajo la guía de profesionales cualificados.

En última instancia, la empatía humana, el juicio clínico y una comprensión profunda de las complejidades de la salud mental siguen siendo esenciales para brindar un apoyo eficaz. La IA tiene el potencial de ser una herramienta valiosa en este campo, pero debe abordarse con cautela y con una comprensión clara de sus limitaciones.