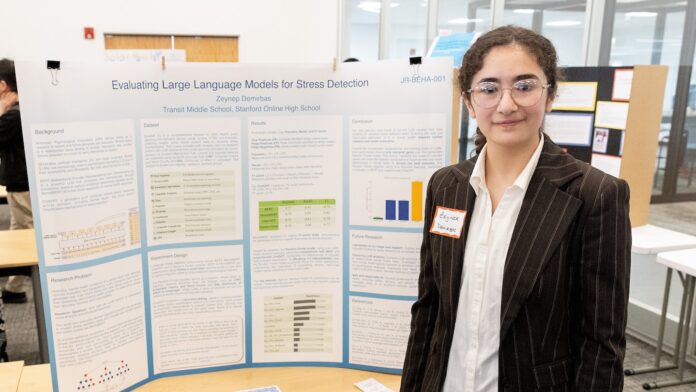

Doświadczenia ucznia gimnazjum z chatbotem opartym na sztucznej inteligencji (AI) uwydatniły obawy związane z wykorzystaniem sztucznej inteligencji do wspierania zdrowia psychicznego. Uczeń biorący udział w Thermo Fisher Scientific Junior Innovators Challenge – konkursie dla uczniów gimnazjów organizowanym przez Society for Science – odkrył, że model sztucznej inteligencji oferował potencjalnie szkodliwe porady, co rodzi pytania o niezawodność tych narzędzi w zarządzaniu dobrostanem emocjonalnym.

Zrozumienie używanych narzędzi

Zanim zagłębimy się w szczegóły odkrycia ucznia, warto zapoznać się z niektórymi kluczowymi technologiami, z którymi się ono wiąże.

- Sztuczna inteligencja (AI): Sztuczna inteligencja odnosi się do systemów, które wykazują inteligentne zachowanie, często poprzez złożone algorytmy. Algorytmy te pozwalają maszynom uczyć się na podstawie danych i podejmować decyzje.

- Modele dużego języka: jest to specyficzny rodzaj sztucznej inteligencji, który koncentruje się na rozumieniu i generowaniu ludzkiego języka. Zostali przeszkoleni na ogromnych ilościach danych tekstowych i mowy, co pozwoliło im przewidywać słowa i wyrażenia oraz odpowiadać na zapytania w sposób niezwykle ludzki. Pomyśl o nich jako o niezwykle wyrafinowanych silnikach przewidywania języka.

- Drzewa decyzyjne i lasy losowe: Są to algorytmy uczące się używane do klasyfikowania informacji lub tworzenia prognoz. Drzewo decyzyjne zadaje serię pytań, zawężając możliwości przy każdej odpowiedzi, podczas gdy model losowego lasu łączy wiele drzew decyzyjnych, aby uzyskać bardziej wiarygodny wynik.

- Parametry: Są to mierzalne warunki lub zmienne w systemie, które można regulować lub badać. Dostrojenie tych parametrów może zoptymalizować wydajność modelu.

Eksperyment studenta i jego konsekwencje

Student badał, w jaki sposób można wykorzystać sztuczną inteligencję do wspierania zdrowia psychicznego, mając na celu opracowanie solidnego systemu. Skoncentrował się na chatbocie zaprojektowanym do rozwiązywania problemów stresowych i sugerowania strategii radzenia sobie. Dostrzegając potencjał sztucznej inteligencji, testy studenta ujawniły niepokojący problem: chatbot czasami udzielał nieodpowiednich lub nawet potencjalnie szkodliwych porad.

Odkrycie to podkreśla ograniczenia obecnych modeli sztucznej inteligencji w przetwarzaniu zawiłości ludzkich emocji i zdrowia psychicznego. Model sztucznej inteligencji nie wziął pod uwagę złożoności indywidualnych okoliczności ani potencjalnych czynników wyzwalających, zamiast tego sugerował ogólne reakcje, które mogą przynieść efekt przeciwny do zamierzonego.

Dlaczego to jest ważne?

Odkrycia te są szczególnie istotne w kontekście rosnącej dostępności aplikacji i chatbotów wykorzystujących sztuczną inteligencję do wspierania zdrowia psychicznego. Chociaż narzędzia te mogą zapewniać wygodne i dostępne wsparcie, nie należy ich uważać za substytut profesjonalnej pomocy psychologa lub innego specjalisty ds. zdrowia psychicznego. Oto dlaczego:

- Brak zrozumienia kontekstu: modele AI działają w oparciu o wzorce zawarte w danych. Mają trudności ze zrozumieniem pełnego kontekstu sytuacji danej osoby, co skutkuje udzielaniem porad, które mogą być nieodpowiednie. Wpływ stresu psychicznego może być zarówno pozytywny, jak i negatywny.

- Potencjał błędu systematycznego: modele sztucznej inteligencji są szkolone na danych i jeśli dane te odzwierciedlają uprzedzenia (związane z płcią, statusem społeczno-ekonomicznym, rasą lub innymi czynnikami), sztuczna inteligencja może utrwalić te uprzedzenia w swoich reakcjach.

- Ryzyko szkodliwych porad: Jak pokazało doświadczenie ucznia, sztuczna inteligencja może udzielać porad niedokładnych, niewrażliwych, a nawet szkodliwych. Objaw może być oznaką wielu różnych urazów lub chorób.

Patrzę w przyszłość

Praca studentki stanowi ostrzeżenie o konieczności dokładnej oceny i regulacji sztucznej inteligencji w zakresie zdrowia psychicznego. Zanim zaczniemy polegać na sztucznej inteligencji w zakresie wsparcia emocjonalnego, należy pamiętać, że narzędzia te są wciąż w fazie rozwoju i mają znaczne ograniczenia.

Celem nie powinno być zastąpienie interakcji człowieka sztuczną inteligencją, ale odpowiedzialne wykorzystanie sztucznej inteligencji jako narzędzia wspomagającego pod okiem wykwalifikowanych specjalistów.

Ostatecznie ludzka empatia, ocena kliniczna i głębokie zrozumienie złożoności zdrowia psychicznego pozostają niezbędne do zapewnienia skutecznej opieki. Sztuczna inteligencja może być cennym narzędziem w tej dziedzinie, należy jednak podchodzić do niej z ostrożnością i pełnym zrozumieniem jej ograniczeń.