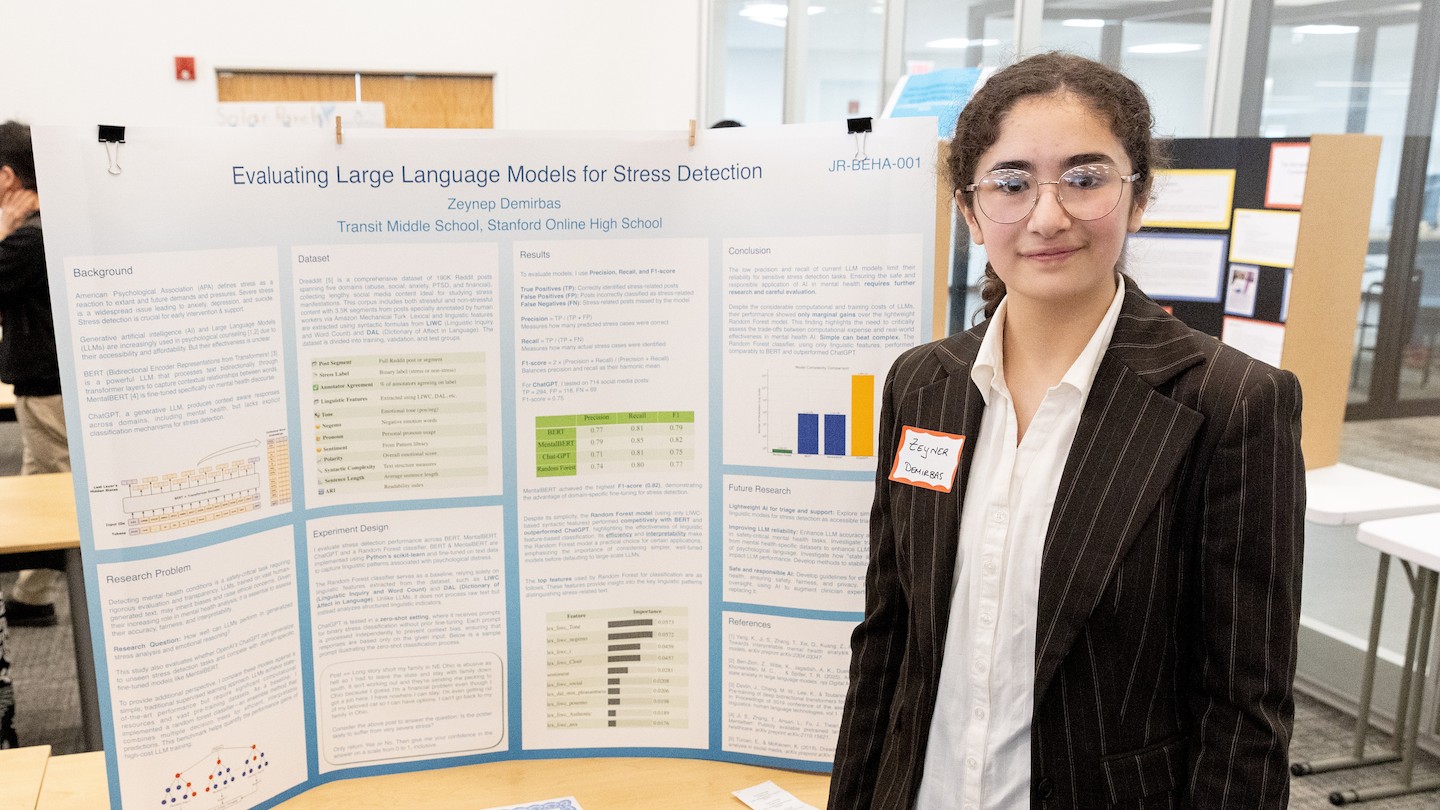

A experiência de um estudante do ensino médio com um chatbot de inteligência artificial (IA) destacou preocupações sobre a dependência da IA para apoio à saúde mental. O estudante, que competiu no Thermo Fisher Scientific Junior Innovators Challenge – uma competição para estudantes do ensino secundário dirigida pela Society for Science – descobriu que um modelo de IA oferecia conselhos potencialmente prejudiciais, levantando questões sobre a fiabilidade destas ferramentas para gerir o bem-estar emocional.

Compreendendo as ferramentas em jogo

Antes de mergulhar nas especificidades das descobertas do aluno, é útil compreender algumas das principais tecnologias envolvidas.

- Inteligência Artificial (IA): IA refere-se a sistemas que exibem comportamento inteligente, muitas vezes por meio de algoritmos complexos. Esses algoritmos permitem que as máquinas aprendam com os dados e tomem decisões.

- Grandes Modelos de Linguagem: Um tipo específico de IA, grandes modelos de linguagem, com foco na compreensão e geração da linguagem humana. Eles foram treinados em enormes conjuntos de dados de texto e fala, o que lhes permite prever palavras e frases e responder a solicitações de uma forma extraordinariamente humana. Pense neles como mecanismos de previsão incrivelmente sofisticados para a linguagem.

- Árvores de decisão e modelos florestais aleatórios: são algoritmos de aprendizagem usados para classificar informações ou fazer previsões. Uma árvore de decisão faz uma série de perguntas, restringindo as possibilidades a cada resposta, enquanto um modelo de floresta aleatória combina múltiplas árvores de decisão para um resultado mais robusto.

- Parâmetros: Estas são as condições ou variáveis mensuráveis dentro de um sistema que podem ser ajustadas ou estudadas. Ajustar esses parâmetros pode otimizar o desempenho do modelo.

A experiência do aluno e suas implicações

O aluno estava explorando como a IA poderia ser usada para fornecer apoio à saúde mental, com o objetivo de desenvolver um sistema confiável. Eles se concentraram em um chatbot projetado para lidar com o estresse e oferecer estratégias de enfrentamento. Embora reconhecesse o potencial da IA, os testes do aluno revelaram um problema preocupante: o chatbot por vezes fornecia conselhos inadequados ou mesmo potencialmente prejudiciais.

Esta descoberta sublinha as limitações dos modelos atuais de IA no tratamento das nuances das emoções humanas e da saúde mental. O modelo de IA não considerou as complexidades das circunstâncias individuais ou dos potenciais gatilhos, oferecendo em vez disso respostas genéricas que poderiam ser contraproducentes.

Por que isso é importante

As descobertas são especialmente relevantes dada a crescente acessibilidade de aplicativos e chatbots de saúde mental alimentados por IA. Embora estas ferramentas possam oferecer apoio conveniente e acessível, não devem ser consideradas um substituto da orientação profissional de um psicólogo ou outro especialista em saúde mental. Aqui está o porquê:

- Falta de compreensão contextual: Os modelos de IA operam com base em padrões de dados. Eles lutam para compreender o contexto completo da situação de um indivíduo, levando a conselhos que podem não ser adequados. O impacto do estresse psicológico pode ser positivo ou negativo.

- Potencial de preconceito: os modelos de IA são treinados com base em dados e, se esses dados refletirem preconceitos (relacionados a gênero, status socioeconômico, raça ou outros fatores), a IA poderá perpetuar esses preconceitos em suas respostas.

- Risco de conselhos prejudiciais: Como a experiência do aluno mostrou, a IA pode fornecer conselhos imprecisos, insensíveis ou até mesmo prejudiciais. Um sintoma pode ser um sinal de qualquer uma das diversas lesões ou doenças.

Olhando para o futuro

O trabalho do aluno serve como um alerta sobre a necessidade de avaliação e regulamentação cuidadosa da IA na saúde mental. Antes de confiar na IA para apoio emocional, é crucial lembrar que estas ferramentas ainda estão em desenvolvimento e têm limitações significativas.

O objetivo não deveria ser substituir a interação humana pela IA, mas sim utilizar a IA de forma responsável como ferramenta de apoio sob a orientação de profissionais qualificados.

Em última análise, a empatia humana, o julgamento clínico e uma compreensão profunda das complexidades da saúde mental continuam a ser essenciais para fornecer um apoio eficaz. A IA tem potencial para ser uma ferramenta valiosa neste domínio, mas deve ser abordada com cautela e com uma compreensão clara das suas limitações.