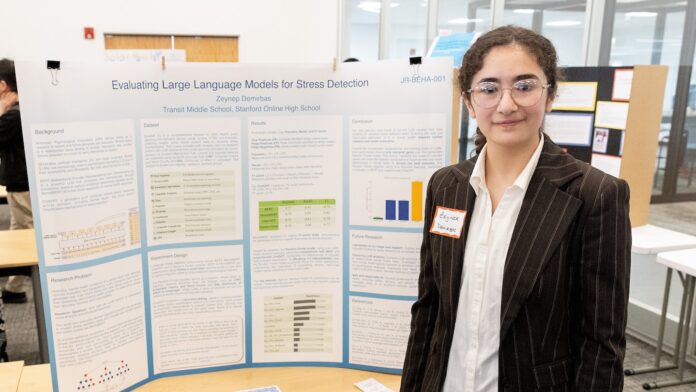

Опыт школьника средней школы с чат-ботом на основе искусственного интеллекта (ИИ) выявил опасения по поводу использования ИИ для поддержки психического здоровья. Школьник, участвовавший в конкурсе Thermo Fisher Scientific Junior Innovators Challenge — конкурсе для школьников средней школы, проводимом Обществом науки — обнаружил, что модель ИИ предложила потенциально вредные советы, что поднимает вопросы о надежности этих инструментов для управления эмоциональным благополучием.

Понимание используемых инструментов

Прежде чем углубляться в детали открытия школьника, полезно понять некоторые ключевые технологии, задействованные в этом вопросе.

- Искусственный интеллект (ИИ): ИИ относится к системам, демонстрирующим разумное поведение, часто посредством сложных алгоритмов. Эти алгоритмы позволяют машинам учиться на данных и принимать решения.

- Большие языковые модели: Это специфический тип ИИ, который фокусируется на понимании и генерации человеческого языка. Они были обучены на огромных массивах текстовых и речевых данных, что позволяет им предсказывать слова и фразы и отвечать на запросы удивительно похожим на человека образом. Представьте их как невероятно сложные предсказательные движки для языка.

- Деревья решений и случайные леса: Это алгоритмы обучения, используемые для классификации информации или прогнозирования. Дерево решений задает серию вопросов, сужая возможности с каждым ответом, в то время как модель случайного леса объединяет несколько деревьев решений для получения более надежного результата.

- Параметры: Это измеряемые условия или переменные внутри системы, которые можно корректировать или изучать. Настройка этих параметров может оптимизировать производительность модели.

Эксперимент школьника и его последствия

Школьник изучал, как ИИ можно использовать для оказания поддержки психическому здоровью, стремясь разработать надежную систему. Он сосредоточился на чат-боте, предназначенном для решения проблем со стрессом и предложения стратегий преодоления. Признавая потенциал ИИ, испытания школьника выявили тревожную проблему: чат-бот иногда давал советы, которые были неуместными или даже потенциально вредными.

Это открытие подчеркивает ограничения текущих моделей ИИ в обработке тонкостей человеческих эмоций и психического здоровья. Модель ИИ не учитывала сложности индивидуальных обстоятельств или потенциальных триггеров, вместо этого предлагая общие ответы, которые могут быть контрпродуктивными.

Почему это важно

Эти результаты особенно актуальны в связи с растущей доступностью приложений и чат-ботов на основе ИИ для поддержки психического здоровья. Хотя эти инструменты могут предлагать удобную и доступную поддержку, их не следует рассматривать как замену профессиональной помощи психолога или другого специалиста в области психического здоровья. Вот почему:

- Отсутствие понимания контекста: Модели ИИ работают на основе закономерностей в данных. Им трудно уловить полный контекст ситуации человека, что приводит к советам, которые могут быть неподходящими. Влияние психологического стресса может быть как положительным, так и отрицательным.

- Потенциал для предвзятости: Модели ИИ обучаются на данных, и если эти данные отражают предвзятость (связанную с полом, социально-экономическим статусом, расой или другими факторами), ИИ может увековечить эти предвзятости в своих ответах.

- Риск вредных советов: Как показал опыт школьника, ИИ может давать советы, которые неточны, бестактны или даже вредны. Симптом может быть признаком любого из многих различных травм или заболеваний.

Взгляд в будущее

Работа школьника служит предостережением о необходимости тщательной оценки и регулирования ИИ в области психического здоровья. Прежде чем полагаться на ИИ для эмоциональной поддержки, важно помнить, что эти инструменты все еще находятся в разработке и имеют значительные ограничения.

Цель не должна заключаться в замене человеческого взаимодействия с ИИ, а в ответственном использовании ИИ в качестве вспомогательного инструмента под руководством квалифицированных специалистов.

В конечном счете, человеческое сочувствие, клиническое суждение и глубокое понимание сложностей психического здоровья остаются необходимыми для оказания эффективной помощи. ИИ может быть ценным инструментом в этой области, но к нему следует подходить с осторожностью и четким пониманием его ограничений.