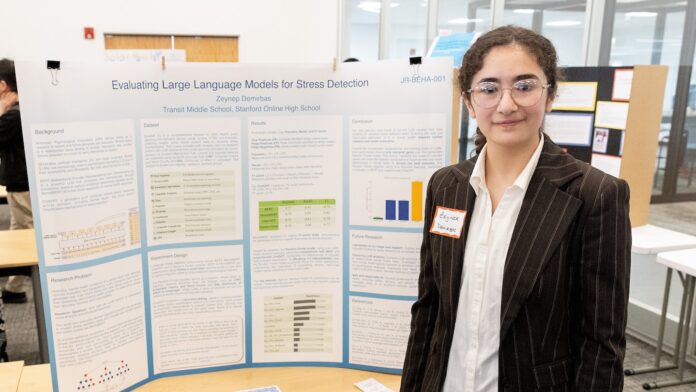

L’expérience d’un collégien avec un chatbot à intelligence artificielle (IA) a mis en évidence des inquiétudes quant au recours à l’IA pour le soutien à la santé mentale. L’étudiant, qui a participé au Thermo Fisher Scientific Junior Innovators Challenge, un concours destiné aux collégiens organisé par la Society for Science, a découvert qu’un modèle d’IA offrait des conseils potentiellement dangereux, soulevant des questions sur la fiabilité de ces outils de gestion du bien-être émotionnel.

Comprendre les outils en jeu

Avant de plonger dans les détails des découvertes de l’étudiant, il est utile de comprendre certaines des technologies clés impliquées.

- Intelligence artificielle (IA) : L’IA fait référence à des systèmes qui présentent un comportement intelligent, souvent grâce à des algorithmes complexes. Ces algorithmes permettent aux machines d’apprendre des données et de prendre des décisions.

- Grands modèles de langage : Un type spécifique d’IA, les grands modèles de langage, se concentrent sur la compréhension et la génération du langage humain. Ils ont été formés sur d’énormes ensembles de données de texte et de parole, ce qui leur permet de prédire des mots et des phrases et de répondre aux invites d’une manière remarquablement humaine. Considérez-les comme des moteurs de prédiction du langage incroyablement sophistiqués.

- Arbres de décision et modèles de forêts aléatoires : Il s’agit d’algorithmes d’apprentissage utilisés pour classer les informations ou faire des prédictions. Un arbre de décision pose une série de questions, réduisant les possibilités à chaque réponse, tandis qu’un modèle de forêt aléatoire combine plusieurs arbres de décision pour un résultat plus robuste.

- Paramètres : Ce sont les conditions ou variables mesurables au sein d’un système qui peuvent être ajustées ou étudiées. Le réglage de ces paramètres peut optimiser les performances du modèle.

L’expérience de l’étudiant et ses implications

L’étudiant étudiait comment l’IA pourrait être utilisée pour fournir un soutien en matière de santé mentale, dans le but de développer un système fiable. Ils se sont concentrés sur un chatbot conçu pour lutter contre le stress et proposer des stratégies d’adaptation. Tout en reconnaissant le potentiel de l’IA, les tests de l’étudiant ont révélé un problème préoccupant : le chatbot donnait parfois des conseils inappropriés, voire potentiellement dangereux.

Cette découverte souligne les limites des modèles d’IA actuels dans la gestion des nuances des émotions humaines et de la santé mentale. Le modèle d’IA ne prend pas en compte la complexité des circonstances individuelles ou des déclencheurs potentiels, proposant plutôt des réponses génériques qui pourraient s’avérer contre-productives.

Pourquoi c’est important

Les résultats sont particulièrement pertinents compte tenu de l’accessibilité croissante des applications de santé mentale et des chatbots basés sur l’IA. Bien que ces outils puissent offrir un soutien pratique et abordable, ils ne doivent pas être considérés comme remplaçant les conseils professionnels d’un psychologue ou d’un autre expert en santé mentale. Voici pourquoi :

- Manque de compréhension contextuelle : les modèles d’IA fonctionnent sur la base de modèles de données. Ils ont du mal à saisir le contexte complet de la situation d’un individu, ce qui conduit à des conseils qui peuvent ne pas convenir. L’impact du stress psychologique peut être positif ou négatif.

- Potentiel de biais : les modèles d’IA sont formés sur des données, et si ces données reflètent des biais (liés au sexe, au statut socio-économique, à la race ou à d’autres facteurs), l’IA peut perpétuer ces biais dans ses réponses.

- Risque de conseils préjudiciables : Comme l’a montré l’expérience de l’étudiant, l’IA peut fournir des conseils inexacts, insensibles ou même nuisibles. Un symptôme peut être le signe de nombreuses blessures ou maladies différentes.

Regarder vers l’avenir

Le travail de l’étudiant sert de mise en garde sur la nécessité d’une évaluation et d’une réglementation minutieuses de l’IA dans le domaine de la santé mentale. Avant de compter sur l’IA pour un soutien émotionnel, il est essentiel de se rappeler que ces outils sont encore en développement et présentent des limites importantes.

L’objectif ne doit pas être de remplacer l’interaction humaine par l’IA, mais d’utiliser l’IA de manière responsable comme outil d’assistance sous la direction de professionnels qualifiés.

En fin de compte, l’empathie humaine, le jugement clinique et une compréhension approfondie des complexités de la santé mentale restent essentiels pour fournir un soutien efficace. L’IA a le potentiel d’être un outil précieux dans ce domaine, mais elle doit être abordée avec prudence et avec une compréhension claire de ses limites.